Непрерывное тестирование систем, используя самые новые инструменты, доступные на рынке

Лука Занотти Фрагонара и Джованни Орландо

Соответствие GxP

Поддержка для соответствия стандартам GxP

ЧитатьПроверка систем искусственного интеллекта и машинного обучения в рамках правил GxP жизненного цикла важна для соблюдения стандартов качества и безопасности регулируемой продукции. В этом блоге подчеркивается важность комплексных протоколов проверки для систем AI/ML в различных секторах, включая фармацевтику и медицинские устройства. В нем подчеркивается преобразующий потенциал систем AI/ML в анализе данных, распознавании образов, прогнозировании и поддержке принятия решений. В статье объясняется, что регулирующие органы, такие как FDA и EMA, ввели строгие требования, чтобы гарантировать безопасность и эффективность продуктов и услуг на основе ИИ. Эти требования охватывают качество данных, алгоритмическую стабильность, производительность модели, объяснимость и документацию. Чтобы соответствовать этим критериям, необходим процесс проверки, чтобы продемонстрировать соответствие нормативным требованиям и обеспечить целостность и точность моделей AI/ML с течением времени. В статье представлена стратегия, основанная на оценке рисков, разработанная PQE, которая включает в себя такие рекомендации, как ASME V&V 40-2018 и GAMP 5v2, для обеспечения соответствия требованиям. Мероприятия по валидации включают оценку рисков модели, планирование валидации, тестирование, документирование, управление изменениями и текущие оценки. В статье подчеркивается важность проверки данных и проектирования на протяжении всего процесса проверки. В целом, в нем подчеркивается важнейшая роль проверки систем AI/ML GxP для подтверждения их достоверности, надежности и признания регулирующими органами.

Системы искусственного интеллекта (ИИ) и машинного обучения (МО) обладают революционным потенциалом для многих отраслей, в том числе для фармацевтики и медицинских устройств. Эти системы могут анализировать большие объемы данных, выявлять закономерности и тенденции, а также делать прогнозы или поддерживать принятие решений, которые могут помочь улучшить результаты лечения пациентов и оптимизировать операции. В частности, несколько примеров применения AI/ML можно найти в:

Однако с ростом зависимости от ИИ и МО в этих областях крайне важно убедиться, что эти системы проверены и работают должным образом. Именно поэтому во втором издании Руководства GAMP 5 «Риск-ориентированный подход к компьютеризированным системам, соответствующим GxP» Приложения были расширены, чтобы охватить эти новые и развивающиеся концепции, которые оказывают значительное влияние на весь сектор наук о жизни.

Обеспечение приемлемого уровня достоверности алгоритмов, управляемых данными, имеет первостепенное значение из-за присущей технологии низкой прозрачности. Следовательно, чтобы гарантировать адекватный уровень качества и снизить высокий риск получения неправильных или ненадежных результатов, регулирующие органы, такие как Управление по санитарному надзору за качеством пищевых продуктов и медикаментов США (FDA) и Европейское агентство по лекарственным средствам (EMA), установили высокие требования к для обеспечения безопасности и эффективности продуктов и услуг на основе ИИ.

Упомянутые выше требования в основном касаются:

Чтобы удовлетворить эти требования, необходим процесс валидации, демонстрирующий соответствие нормативным требованиям и поддерживающий целостность и точность любой модели AI или ML с течением времени.

Основываясь на самых последних правилах, которые были выпущены в отношении валидации AI/ML, Центр компетенций по передовым технологиям PQE разработал эффективную стратегию, основанную на оценке рисков, для достижения требуемого уровня соответствия:

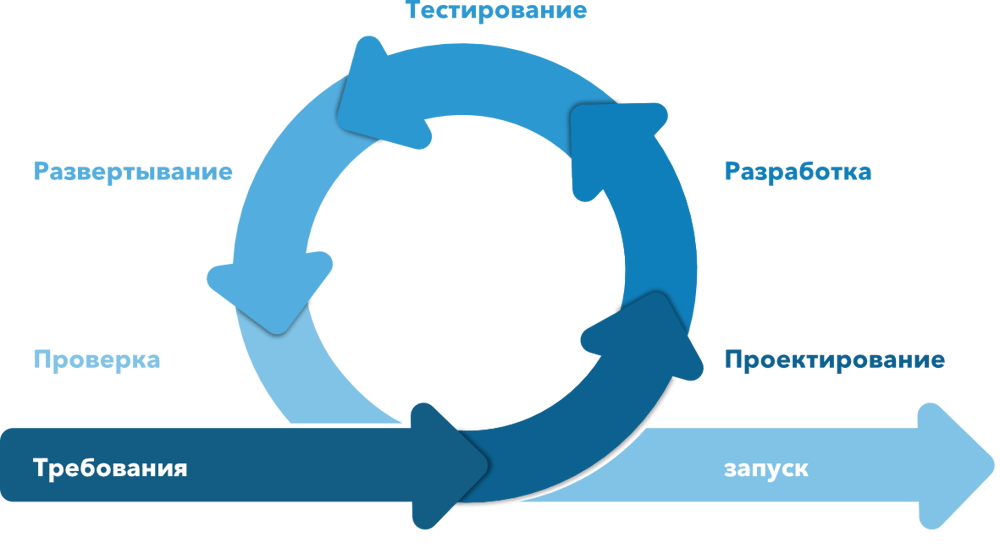

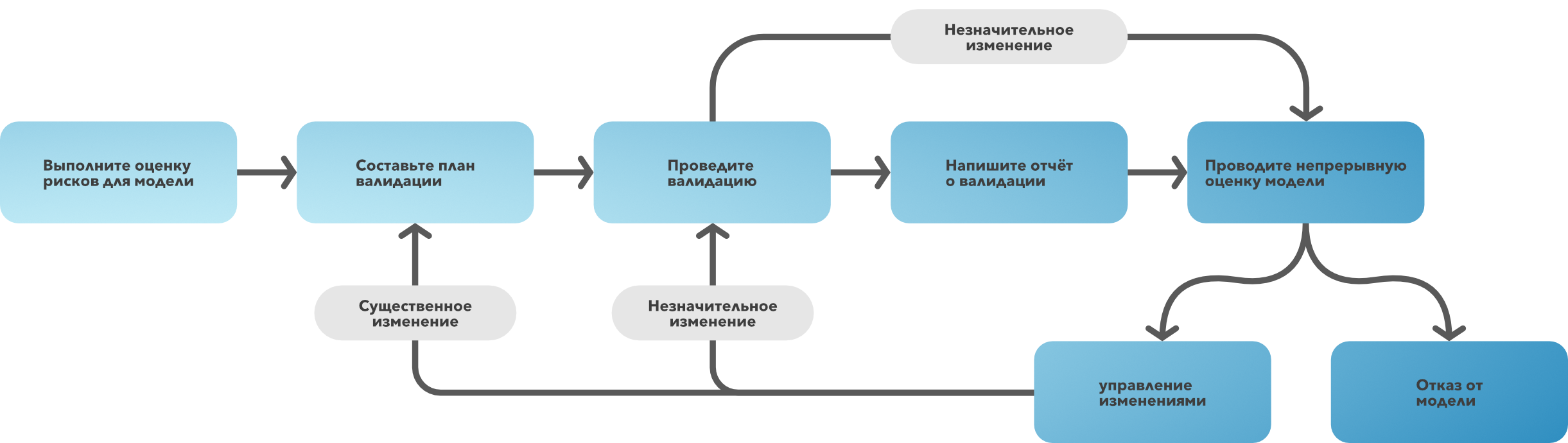

Объединив содержание вышеупомянутых руководств с новым подходом Computer Software Assurance (CSA) и методологией Agile Development, эксперты группы PQE разработали специальную структуру, гарантирующую приемлемый уровень достоверности проверяемых алгоритмов.

Рис. 1. Схема подхода CSA

Рис. 2 Гибкая методология (Agile)

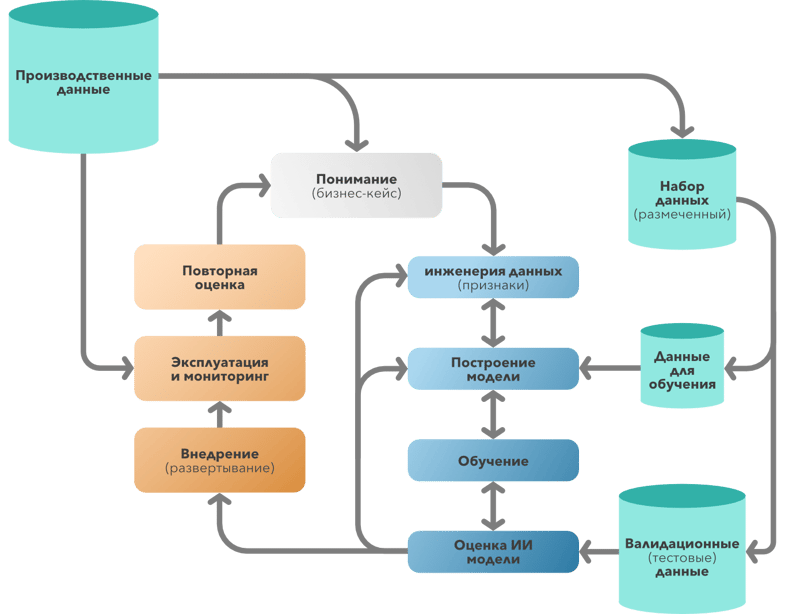

Рис. 3. Жизненный цикл проверки модели

Действия по валидации, которые должны выполняться в модели AI/ML, всегда должны включать следующие действия:

Как уже упоминалось, процесс валидации также должен опираться на подход CSA, чтобы уменьшить предполагаемые усилия, предоставить больше места для фазы критического мышления и задач обеспечения, оптимизации деятельности по тестированию и сокращения документации.

В частности, ядром процесса является определение риска. Это приводит к достижению баланса в деятельности по валидации, гарантируя надлежащий уровень приемлемости со стороны регулирующих органов и разумный объем документации, которую необходимо создать и поддерживать.

Параллельно необходим процесс проверки данных, чтобы выполнить все требования к целостности и качеству данных.

Рис. 4. Жизненный цикл данных , интегрированный с жизненным циклом модели

В частности, невозможно проверить алгоритм AI/ML, не позаботившись о формате данных и о процессе обработки данных в целом.

Таким образом, проверка систем GxP, включающих модели/алгоритмы AI/ML, является важным шагом в обеспечении качества и безопасности регулируемых продуктов. Важно учитывать такие факторы, как качество данных, алгоритмическую стабильность, производительность модели, объяснимость модели и документации, чтобы обеспечить надежность и эффективность этих моделей.

Команда PQE Advanced Technologies разработала надежную стратегию для достижения соответствия, сочетая основные этапы проверки с принципами CSA и Agile Methodologies. Это оптимизирует деятельность, уравновешивая объем документации, которая должна быть подготовлена, и получая, с другой стороны, надлежащий уровень нормативного признания, а также принимая во внимание рабочие процессы очистки данных и обработки данных, которые сильно влияют на эффективность и обслуживание модели.